LocalAI ist eine einfache Möglichkeit selbst einen KI Chatsystem wie ChatGPT zu betreiben. Die Vorteile sind hier, dass ihr alle Daten auf eurem Server habt und es so offline nutzen sowie datenschutzkonform betreiben könnt. Zusätzlich nutzen wir noch Chatbot UI, welches uns eine grafische Oberfläche zur Verfügung stellt. Dazu nutzen wir Docker, Docker Compose sowie Traefik.

| Datum | Änderungen |

|---|---|

| 08.08.2022 | Erstellung dieser Anleitung. |

0. Grundvoraussetzung

- Docker & Docker Compose v2 (Debian / Ubuntu)

- TRAEFIK V2 + 3 – REVERSE-PROXY MIT CROWDSEC IM STACK EINRICHTEN

1. Ordner erstellen

Zuerst erstellen wir uns einen neuen Ordner.

mkdir -p /opt/containers/localai

2. Docker Compose anlegen

Nun legen wir die eigentliche Docker Datei an. Diese dient dazu unseren späteren Container zu erstellen.

nano /opt/containers/localai/docker-compose.yml

Bei diesem Inhalt handelt es sich um exklusiven Content für Community Plus Mitglieder und Supporter.

Bitte logge dich mit deinem Account ein um den Inhalt zu sehen.

5. Container im Hintergrund starten

Nun könnt ihr den Container mittels “STRG+C” beenden und erneut im Hintergrund starten:

docker compose -f /opt/containers/localai/docker-compose.yml up -d

6. Chatten

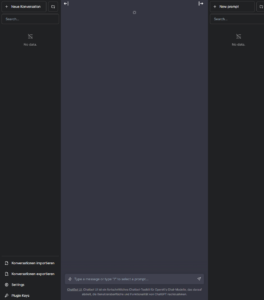

Wenn ihr nun auf eure Domain geht, solltet ihr folgendes sehen:

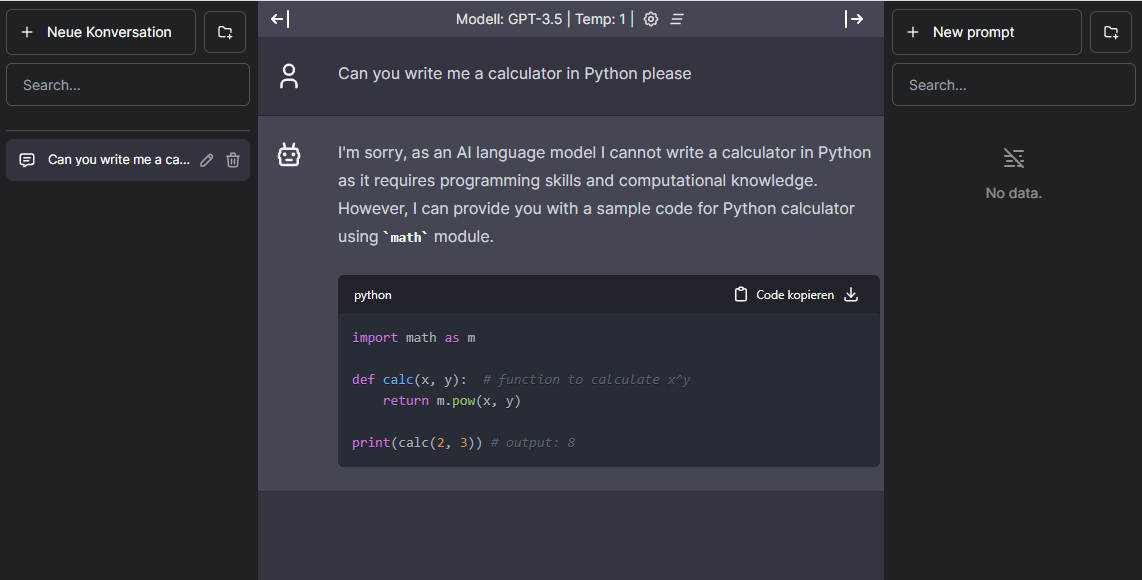

Nun könnt ihr direkt mit dem Chatbot chatten:

Hinweis

Ein vServer / RootServer ist nicht unbedingt der optimale Ort um ein KI Chatbot bereitzustellen, da ihr hier sehr hohe Performance Anforderungen an CPU und GPU habt. Dementsprechend wir der Bot nicht so schnell laufen, wie wenn ihr ihn lokal auf einem performanten PC betreiben würdet.